B-모드 및 초음파 변형탄성 영상 이용한 딥러닝 기반 다중 모달 융합 네트워크 개발

-

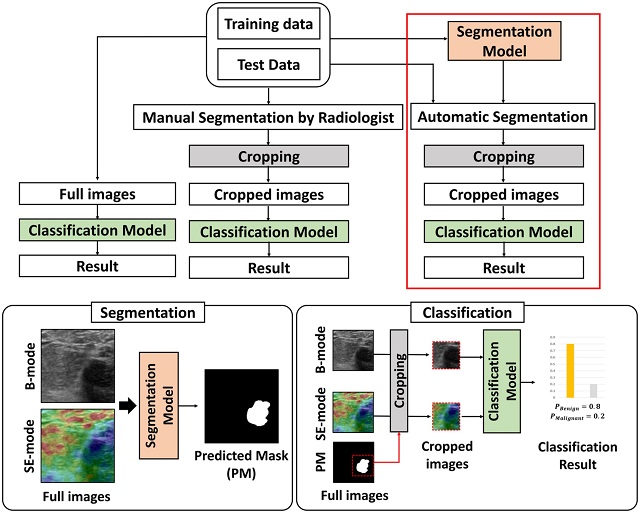

- ▲ 연구 관련 그림.ⓒ포스텍

POSTECH(포항공과대학교, 총장 김무환) 연구팀이 정확하게 유방암을 진단할 수 있는 인공지능 초음파 네트워크 시스템을 개발했다.POSTECH IT융합공학과·전자전기공학과·기계공학과 김철홍 교수, 전자전기공학과 미스라 삼파(Misra Sampa) 씨, 전자전기공학과 윤치호 씨 연구팀이 B-모드(B-mode)와 초음파 변형 탄성 영상(Strain Elastography Ultrasound Images)을 함께 이용해 '더' 정확하게 유방암을 분할·분류하는 딥러닝 기반 다중 모달 융합 네트워크를 개발했다.이 연구성과는 바이오메디컬 분야 권위지인 ‘바이오엔지니어링 앤 트랜스레이셔널 메디슨(Bioengineering & Translational Medicine)’에 게재됐다.초음파 검사는 유방 병변을 평가하기 위한 주요 의료 영상 양식 중 하나이다. 악성 병변과 양성을 구별하기 위해 컴퓨터 보조 진단(CAD) 시스템은 병변의 특징을 자동으로 세분화하고 식별함으로써 방사선 전문의에게 큰 도움을 준다.연구팀은 B 모드와 변형 탄성 그래피(SE, Strain Elastohraphy-mode) 이미지를 모두 활용해 병변을 분할한 다음, 악성에서 양성을 분류하는 딥러닝(DL) 기법을 결합하는 방법을 제안했다.먼저, 병변의 분할을 위해 가중 스킵 커넥션 방법을 사용해 서로 다른 영상 양식에 최적의 가중치를 적용하는 ‘가중 멀티모달 U-Net(W-MM-U-Net) 모델’을 개발했다.양성·악성 병변을 분류하기 위해 잘린 B-모드와 SE-모드 초음파(US) 병변 이미지에 대한 ‘다중 모드 융합 프레임워크(MFF)’를 제시했다.MFF는 통합 피처 네트워크(IFN)와 의사 결정 네트워크(DN)로 구성된다. 제안된 MFF 방법은 최근의 다른 융합 방법과 달리 B-모드 및 SE-모드 US 이미지를 사용하여 훈련된 컨볼루션 신경망(CNN)에서 보완 정보를 동시에 학습할 수 있다.CNN의 기능은 멀티모달(EmbraceNet) 모델을 사용해 조립되고, DN은 이러한 기능을 사용해 이미지를 분류한다.실제 임상 데이터로 실험한 결과, 양성 환자 7명을 5번 중 3번 양성으로, 악성 환자 6명을 5번 중 5번 양성으로 예측했다.이는 연구팀이 제안한 방법이 지금까지의 단일·다중 초음파 방법을 능가하는 것으로 나타났다. 이는 잠재적으로 US 이미지에서 유방암 탐지를 위한 방사선 전문의의 분류 정확도를 향상시킬 것으로 기대된다.김철홍 교수는 “입력 영상의 중요도를 판단하고 적절한 가중치를 자동으로 할당하여 더 정확한 병변 분할을 가능하게 했다”며 “딥러닝 모델과 앙상블 모델을 동시에 학습시켜 기존의 단일 모드나 다른 다중 모드에 비해 훨씬 뛰어난 분류 성능을 보였다”고 말했다.한편, 이 연구는 과학기술정보통신부, 교육부, 한국전자통신연구원(ETRI)의 지원으로 이뤄졌다.